|

Sehr geehrte Interessierte am Dritten Gleichstellungsbericht,in unserem Oktober-Newsletter geben wir Ihnen einen Einblick in das Gutachten-Kapitel zu Algorithmen in der Personalauswahl. Zusätzlich zur Einführung in die Kapitelinhalte geht die Sachverständige Prof. Dr. Katja Nebe im Format „Drei Fragen an…“ konkret auf die Herausforderungen und Handlungsoptionen von Betriebs- und Personalräten ein. Passend dazu möchten wir Sie auf die Veröffentlichung des Themenblatts „Algorithmen und Diskriminierung“ hinweisen. Wir freuen uns, Ihnen nach dem Kick-Off-Event der Veranstaltungsreihe „Digitalisierung geschlechtergerecht gestalten“, die von der EAF in Kooperation mit uns und dem Harriet-Taylor-Mill-Institut organisiert wird, vom erfolgreichen Start der Reihe berichten zu können. Auch zum ersten Roundtable „Technikgestaltung“ möchten wir herzlich einladen, mehr Informationen im entsprechenden Abschnitt unter „Aktuelles“. Dokumentationen vergangener Veranstaltungen und Anmeldemöglichkeiten zu kommenden Events finden Sie wie immer am Ende des Newsletters. Wir wünschen eine erkenntnisreiche Lektüre! |

Inhalt dieser AusgabeAktuelles: Neues Themenblatt veröffentlicht | Kick-Off-Veranstaltung „Digitalisierung geschlechtergerecht gestalten“ großer Erfolg | Erster Roundtable „Diskriminierungsfreie Technikentwicklung und -gestaltung“ | Abschlusssitzung der Sachverständigenkommission Einblick in das Gutachten: Algorithmen in der Personalauswahl | 3 Fragen an Katja Nebe | Tipps zum Thema (Lesen, Sehen, Hören) Eindrücke aus der Arbeit der Geschäftsstelle und der Kommission: Vergangene und kommende Veranstaltungen |

|

Themenblatt 5 "Algorithmen und Diskriminierung" veröffentlicht

Diesen Monat wird ein weiteres Themenblatt veröffentlicht:

|

Kick-Off-Veranstaltung „Digitalisierung geschlechtergerecht gestalten“ voller Erfolg

Am 10. September startete die Veranstaltungsreihe zum Gutachten für den Dritten Gleichstellungsbericht mit beachtlichen über 200 Anmeldungen. Nach der Begrüßung führten Kommissionsvorsitzende Prof. Dr. Aysel Yollu-Tok und die Leitung des Referats Grundsatzfragen Gleichstellung im BMFSFJ Angelika Engstler in die Bedeutung und Inhalte des Dritten Gleichstellungsberichts ein. Im Anschluss fanden sechs Diskussionsrunden zu den Themen Technikentwicklung, Gründungen, Plattformökonomie, Arbeitswelt, Vereinbarkeit und Digitale Gewalt mit den anwesenden Stakeholdern statt. Die Teilnehmenden finden eine Dokumentation der Veranstaltung auf der Veranstaltungsseite. Zu den dort andiskutierten Themenkomplexen werden innerhalb der nächsten Monate fünf Roundtable-Veranstaltungen stattfinden, in denen die Handlungsempfehlungen des Gutachtens vertieft diskutiert und – jenseits der Wiederholung der Problemfokussierung – konkrete nächste Schritte zu ihrer Umsetzung erarbeitet werden sollen. Die Roundtables sind eine Gelegenheit für Akteur*innen in Politik, Wissenschaft, Wirtschaft und Zivilgesellschaft gemeinsam darüber ins Gespräch zu kommen, wie die Digitalisierung im jeweiligen Themenbereich geschlechtergerecht gestaltet werden kann. Die Daten und Themen der fünf Roundtables bis Mitte Januar sind auf der Website der Veranstaltungsreihe https://digitalisierung-geschlechtergerecht.org/ zu finden. |

Erster Roundtable zu Technikentwicklung und -gestaltung der Reihe „Digitalisierung geschlechtergerecht gestalten“Der erste Roundtable zum Thema „Diskriminierungsfreie Technikentwicklung und -gestaltung“ wird am 11. November von 16 bis 18 Uhr digital stattfinden. Zu Beginn wird Prof. Dr. Claude Draude, eine der Sachverständigen des Gutachtens für den Dritten Gleichstellungsbericht, darlegen, welche Pflöcke für eine geschlechtergerechte Technikentwicklung eingeschlagen werden müssen. Rosmarie Steininger, Initiatorin des vom BMAS geförderten Projekts „KIDD – KI im Dienste der Diversität“, wird in einem weiteren Kurzinput den Fokus auf die Frage legen, welche Vorschläge im KIDD-Projekt für partizipative und inklusive Prozesse zur Einführung von Künstliche-Intelligenz-Systemen entwickelt werden. Anschließend werden Akteur*innen aus dem Feld der praxisnahen Umsetzung und Gestaltung ins Gespräch kommen und gemeinsam an Handlungsoptionen feilen. Wenn Sie im Feld arbeiten und sich für Gleichstellung und Diskriminierungsfreiheit in der Technikgestaltung einsetzen, laden wir auch Sie herzlich zu diesem Roundtable ein. Bitte registrieren Sie sich dafür über die Veranstaltungswebsite. |

Abschlusssitzung der SachverständigenkommissionDie Sachverständigenkommission trat am 24.9. noch einmal zu einer Abschlusssitzung zusammen, die Gelegenheit zum Rück- und Ausblick bot. Nachdem die meisten Arbeitssitzungen der Kommission während der Gutachtenerstellung im vergangenen Jahr digital stattfinden mussten, war es schön, nun abschließend noch einmal mit der Sachverständigenkommission, der Geschäftsstelle und den Vertreter*innen des Ministeriums physisch zusammenzukommen. |

|

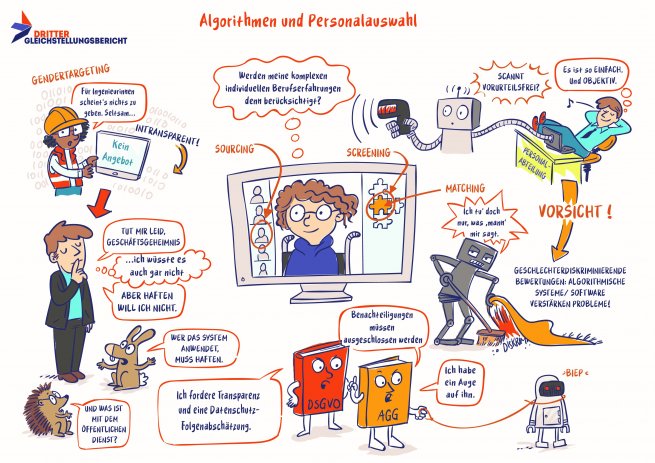

Algorithmen und Personalauswahl

Illustrationen von Ka Schmitz / Imke Schmidt-Sári Von Algorithmen ist oft im Zusammenhang mit Sozialen Medien und Filterblasen die Rede. Die Berechnungen und Prognosen algorithmischer Systeme spielen jedoch auch in anderen Bereichen des Lebens und Arbeitens eine zunehmende Rolle, unter anderem in der Suche nach und Entscheidung über Personal. So hilft z. B. Software beim Sourcing, dem Durchsuchen von Karriereportalen wie LinkedIn oder Xing, um passende Kandidat*innen für eine Stelle zu finden oder Arbeitsuchenden bestimmte Stellen anzuzeigen. Digitale Tools zum Bewerber*innen-Screening filtern die Personen aus dem Pool heraus, die laut Berechnungen am besten ins Team oder zu einer Stelle passen. Und Videoanalyse-Software kann dazu genutzt werden, Bewerbungsgespräche nach psychologischen Vorgaben auszuwerten, den Bewerber*innen bestimmte Persönlichkeitsmerkmale zuschreiben und entsprechende Vorschläge für die Auswahl machen. Oft wird derartige Software mit der Hoffnung eingesetzt, menschliche Vorurteile zu umgehen und Prozesse objektiver zu gestalten. Bei all diesen Schritten bestehen beim Einsatz algorithmischer Systeme jedoch erhebliche Diskriminierungsrisiken in Bezug auf das Geschlecht. Auch rassistische und klassistische Diskiminierung, Diskriminierung aufgrund von Behinderung, der Religionszugehörigkeit, des Alters oder der sexuellen Orientierung können durch Software reproduziert werden. So werden manche Stellen beispielsweise eher Männern als Frauen angezeigt (Gender Targeting) oder Software wie ein Videoanalyse-Programm bewertet Bewerbungsgespräche anders, wenn die interviewte Person ein Kopftuch trägt. Diskriminierung kann aus unterschiedlichen Gründen in algorithmische Systeme einfließen und durch diese reproduziert werden. In der Entwicklung fließen die Vorannahmen der Entwickler*innen mit ein. Es mangelt oft an Expertise zu Diskriminierungsrisiken, um dies zu verhindern. Meist sind die Testgruppen für die Software die häufig homogenen Entwickler*innenteams und es fehlt die Einbeziehung der später betroffenen Personen. Dadurch oder durch verzerrte Datensätze, mit denen das algorithmische System trainiert wird, sind oft auch die Vorschläge und Prognosen verzerrt. Teilweise sind aber auch die Zielsetzung und Modelle, an denen sich die Entwicklung orientiert, Grund für diskriminierende Effekte: Wird ein Programm z. B. daraufhin trainiert, zu den Menschen im Team ähnliche Bewerber*innen als passender zu bewerten, bleiben Teams systematisch homogen. Oft werden vorhandene Diskriminierungsrisiken durch den Mythos von Neutralität und Objektivität der Technik verschleiert. Zudem sind die Gründe für Prognose und Vorschläge algorithmischer Systeme im Nachhinein meist weder für die Personen, die sie einsetzen, noch für Personen, die dadurch bewertet werden, vollkommen nachvollziehbar. Die Sachverständigenkommission für den Dritten Gleichstellungsbericht der Bundesregierung hat Handlungsempfehlungen entwickelt, die dafür sorgen sollen, dass Diskriminierungen verhindert werden. So empfiehlt die Kommission beispielsweise, Systeme immer einer Risikoprüfung zu unterziehen, etwa durch Aufsichtsbehörden wie bspw. Landesdatenschutzbeauftragte oder Landesämter für Gewerbeaufsicht bzw. Arbeitsschutz mit zusätzlichen Kapazitäten. Datenschutzfolgeabschätzungen sollten verpflichtend werden und Software entwickelnde Unternehmen sollen für größtmögliche Transparenz hinsichtlich der Funktionsweise der Software sorgen, indem sie technische Spezifikationen, Programmiervorgaben, Anforderungskataloge, Dokumentationen und Quellcodes offenlegen. Geschlechtsbezogene Daten oder andere geschützte Kategorisierungen sollen nur in Ausnahmefällen verarbeitet werden dürfen. Die Auskunftsansprüche über den Einsatz algorithmischer Systeme sollen insbesondere für Arbeitnehmende und Bewerber*innen konkretisiert werden. Um Arbeitnehmer*innen davon zu entlasten, bei Verstößen gegen ihre*n Arbeitgeber*in vorzugehen und um Kompetenzen und Ressourcen zu bündeln, sind Antidiskriminierungsstellen und -verbände mit weiteren Kompetenzen und Befugnissen auszustatten, konkret z. B. mit einem Verbandsklagerecht. Zudem sollen Betriebs- und Personalräte entsprechend geschult werden, sodass sie über ausreichende digitalisierungsbezogene Kompetenzen verfügen. Die Sachverständige Prof. Dr. Katja Nebe geht im folgenden Interview im Detail auf die Herausforderungen für Betriebe ein und erläutert rechtliche und betriebliche Handlungsoptionen. |

3 Fragen an: Prof. Dr. Katja Nebe

Prof. Dr. Katja Nebe ist Professorin der Rechtswissenschaften mit Schwerpunkt Bürgerliches Recht, Arbeitsrecht und Recht der Sozialen Sicherheit an der Martin-Luther-Universität Halle-Wittenberg. Sie brachte Ihre Expertise als Kommissionsmitglied ins Gutachten zum Dritten Gleichstellungsbericht ein.

1. Was macht das Thema „Algorithmen und Personalauswahl“ aus Ihrer Sicht so wichtig für Arbeitnehmer*innen und Arbeitgeber*innen? Eine nachhaltige Unternehmensführung hängt von einer guten und vorausschauenden Personalplanung ab. Die Personalauswahl selbst macht einen beachtlichen Teil der Personalplanung aus, nicht nur bei der Einstellung und damit beim Zugang zur Arbeit, sondern auch bei Beförderungen, bei der Inanspruchnahme von Qualifizierungen, aber auch bei einer eventuellen Reduzierung von Personal, sprich bei Personalabbau. Der Einsatz neuer Auswahlmethoden muss daher sehr aufmerksam bedacht werden. Denn Personalauswahlentscheidungen werden auf der Grundlage verschiedenster Daten zur fachlichen und persönlichen Eignung, aber auch anhand sozialer Gesichtspunkte getroffen. Mit der computergestützten Datenverarbeitung lassen sich Daten von und über Personen in großer Menge schnell zusammenstellen und auswerten. Hierin wird die Chance gesehen, dass Auswahlentscheidungen neutral und ohne von Menschen gemachte diskriminierende Einflüsse zustande kommen. Aber auch hier gilt „Traue keiner Statistik“, denn auch ein automatisierter Rechenprozess kann Verzerrungen enthalten, je nachdem, welche Daten in die Berechnung einbezogen oder wie gewichtet werden. Die Rechenverfahren, also die Algorithmen digitaler Personalauswahlsysteme werden zunehmend komplexer. Dazu gehören auch sogenannte selbstlernende Rechensysteme, die auf der Basis selbstständiger Verknüpfungen schier unzähliger Daten ein Auswahlergebnis ausgeben. Je nachdem, auf welche Daten ein solcher Algorithmus zugreifen kann und welche Wechselwirkungen zwischen verschiedenen Daten bisher statistisch besonders häufig waren, wird das Risiko stereotyper und damit auch diskriminierender Entscheidungen größer. Beide Seiten, Arbeitgeber*innen wie Arbeitnehmer*innen, müssen ein sehr hohes Interesse an soliden Auswahlprozessen haben. Entsprechend sensibel und planvoll müssen daher neue Methoden, auch technische und technologische, hinsichtlich ihrer Einflüsse auf Auswahl und Ergebnis abgeschätzt und fortlaufend überprüft werden. 2. Wie können Interessenvertretungen von Arbeitnehmer*innen sicherstellen, dass durch algorithmische Systeme niemand rassistisch, wegen der ethnischen Herkunft, des Geschlechts, der Religion oder Weltanschauung, einer Behinderung, des Alters oder der sexuellen Identität benachteiligt wird (§1 AGG)? Auf zweierlei Wegen – einmal prozedural, d. h. Interessenvertretungen können Einfluss auf die Entscheidungsprozesse nehmen. Das beginnt schon bei der Mitsprache bei der Planung über den Einsatz neuer Methoden, also auch bei der Entscheidung über algorithmische Systeme. Bei Bedarf können sich Betriebsräte externen Sachverstand besorgen. Insoweit hat das Mitte Juni diesen Jahres in Kraft getretene Betriebsrätemodernisierungsgesetz die Rechte des Betriebsrats gestärkt. Und dann muss natürlich auch geschaut werden, welche Technologie eingesetzt werden soll. Nicht nur Betriebs- und Personalräte, ebenso Schwerbehindertenvertretungen, Gleichstellungsbeauftragte usw. sind dem Querschnittsthema „Diskriminierungsschutz“ verpflichtet. Das ergibt sich u.a. aus § 17 Allgemeines Gleichbehandlungsgesetz (AGG). Sollen also Algorithmen bei welcher personenbezogenen Auswahlentscheidung auch immer eingesetzt werden, müssen die Interessenvertretungen bei etwaigen Diskriminierungsrisiken den Arbeitgeber auffordern, den Einsatz zu unterlassen. Je unüberschaubarer ist, welche Datenquellen bei der algorithmischen Berechnung genutzt werden, umso größer ist das Risiko verzerrender Wirkungen. Diesen muss vorgebeugt werden. Im besten Fall kommen Interessenvertretungen mit dem Arbeitgeber im Wege von Kollektivvereinbarungen über den Einsatz geprüfter Systeme und eine laufende Wirkungskontrolle überein. Für die Abwägung des Für und Wider des Einsatzes eines algorithmischen Systems kommt z. B. der Prüfleitfaden zum Einsatz von KI im Personalmanagement von AlgorithmWatch in Frage. Bestehende Systeme können mit dem Reflexionskatalog des Gerd-Modells, das eine geschlechtergerechte und diskriminierungsfreie Softwareentwicklung unterstützt, hinterfragt werden. 3. Auf EU-Ebene wurde Ende April dieses Jahres ein Entwurf für ein „Gesetz über Künstliche Intelligenz“ (KI-VO-E) vorgelegt. Auch KI-Algorithmen, die im Personalbereich genutzt werden, sollen reguliert werden. Sind die dort vorgeschlagenen rechtlichen Rahmenbedingungen geeignet für einen Diskriminierungsschutz von Arbeitnehmer*innen? Die Rahmenbedingungen enthalten einige gute Ansatzpunkte, die auch dem Diskriminierungsschutz dienen können. Der Regulierungsvorschlag fußt auf einem risikobasierten Ansatz, der sich an den Grundwerten der Union – zu denen die Geschlechtergleichstellung und die Diskriminierungsfreiheit gehören – orientiert. Der Verordnungs-Entwurf sieht gestufte Vorkehrungen vor; so sind für solche KI-Systeme, bei denen nur ein geringes oder minimales Risiko gesehen wird, auch nur wenige verbindliche Anforderungen formuliert. Im Wesentlichen soll bei diesen Systemen durch freiwillige Selbstverpflichtungen der Anbieter Übereinstimmung, also Compliance mit den Anforderungen der KI-VO-E erreicht werden (Art. 69 KI-VO-E). Der Deutsche Juristinnenbund e.V. hat in seiner Stellungnahme zum Entwurf zu Recht darauf hingewiesen, dass das zu wenig ist: in der Vergangenheit hat sich gezeigt, dass Freiwilligkeit im Hinblick auf die Geschlechtergleichstellung und den Diskriminierungsschutz nicht ausreicht, vor allem dann nicht, wenn die Maßnahmen mit Aufwand und Kosten verbunden sind. Für Systeme im Bereich Beschäftigung sieht der Entwurf ein „hohes Risiko“, nicht jedoch ein Risiko auf höchster Stufe (das hieße ein „unannehmbares Risiko“) für KI in Personalentscheidungen vor. Damit wäre die Folge kein Verbot, sondern nur strenge Schutzvorgaben. Ich habe Zweifel, ob angesichts der bisherigen Dynamik durch den hohen Angebotsdruck das notwendige Schutzniveau erreicht wird. Auf jeden Fall stellen sich für alle Beteiligten erhebliche Herausforderungen für eine geschlechtergerechte und diskriminierungsfreie Personalplanung. Zum Weiterlesen: Die Auswertung "Machine-Learning-Anwendungen in der betrieblichen Praxis" von Andree Thieltges (2020) zeigt Handlungsmöglichkeiten für Interessensvertretungen anhand von Regelungspunkten aus insgesamt 29 abgeschlossenen Betriebs- und Dienstvereinbarungen.

|

Tipps zum Thema (Lesen, Sehen, Hören, Spielen)Lesen:

Sehen:

Hören:

Spielen:

|

|

Ausgewählte vergangene und kommende Veranstaltungen

Die Sachverständigen und die Geschäftsstelle stellen die Inhalte des Gutachtens bei verschiedensten Veranstaltung vor. Einen Überblick zu Formaten und Inhalten bekommen Sie im Folgenden. Sie können sich gern mit entsprechenden Anfragen für Vorträge per Email an uns wenden.

Ihre Geschäftsstelle für den Dritten Gleichstellungsbericht |

|